以下文章來源于機器之心SOTA模型 ,作者機器之心SOTA模型

機器之心專欄

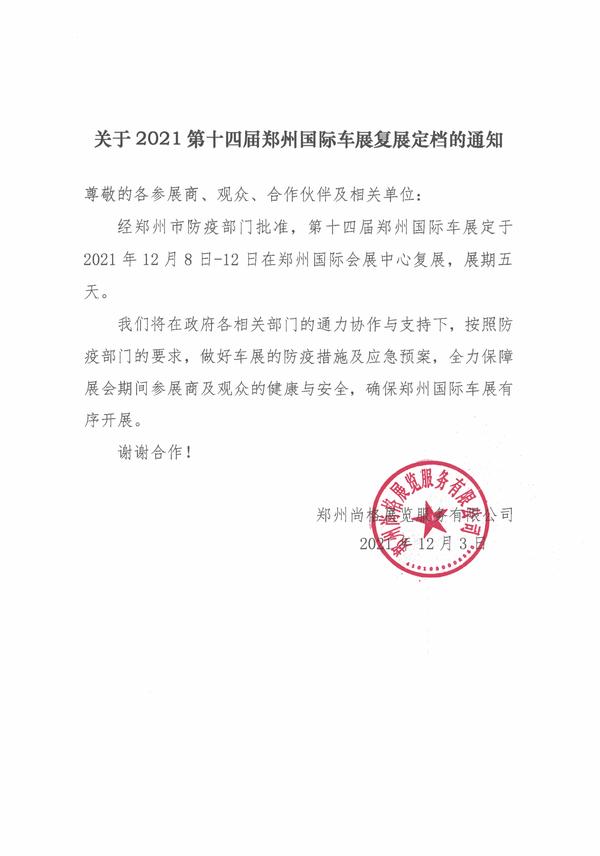

(相關(guān)資料圖)

(相關(guān)資料圖)

本專欄由機器之心SOTA!模型資源站出品,每周日于機器之心公眾號持續(xù)更新。

本專欄將逐一盤點自然語言處理、計算機視覺等領(lǐng)域下的常見任務(wù),并對在這些任務(wù)上取得過 SOTA 的經(jīng)典模型逐一詳解。前往 SOTA!模型資源站(sota.jiqizhixin.com)即可獲取本文中包含的模型實現(xiàn)代碼、預(yù)訓(xùn)練模型及 API 等資源。

本文將分 3 期進行連載,共介紹 16個在語音識別任務(wù)上曾取得 SOTA 的經(jīng)典模型。

第 1 期:SRCNN、DRCN、FSRCNN、ESPCN、SRGAN、RED

第 2 期:VDSR、DRRN、LapSRN、RCAN、DSRN

第 3 期:SFT-GAN、CSRCNN、CSNLN、HAN+、Config (f)

您正在閱讀的是其中的第 1 期。前往 SOTA!模型資源站(sota.jiqizhixin.com)即可獲取本文中包含的模型實現(xiàn)代碼、預(yù)訓(xùn)練模型及 API 等資源。

本期收錄模型速覽

| 模型 | SOTA!模型資源站收錄情況 | 模型來源論文 |

|---|---|---|

| SRCNN | https://sota.jiqizhixin.com/project/srcnn收錄實現(xiàn)數(shù)量:57支持框架:PyTorch、TensorFlow、MindSpore | Image Super-Resolution Using Deep Convolutional Networks |

| DRCN | https://sota.jiqizhixin.com/project/drcn收錄實現(xiàn)數(shù)量:1支持框架:TensorFlow | Deeply-Recursive Convolutional Network for Image Super-Resolution |

| FSRCNN | https://sota.jiqizhixin.com/project/fsrcnn收錄實現(xiàn)數(shù)量:8支持框架:PyTorch、TensorFlow | Accelerating the Super-Resolution Convolutional Neural Network |

| ESPCN | https://sota.jiqizhixin.com/project/espcn收錄實現(xiàn)數(shù)量:14支持框架:PyTorch、TensorFlow | Real-Time Single Image and Video Super-Resolution Using an Efficient Sub-Pixel Convolutional Neural Network |

| SRGAN | https://sota.jiqizhixin.com/project/srgan收錄實現(xiàn)數(shù)量:4支持框架:PyTorch、TensorFlow | Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network |

| RED | https://sota.jiqizhixin.com/project/red30-2收錄實現(xiàn)數(shù)量:13 支持框架:TensorFlow | Image Restoration Using Convolutional Auto-encoders with Symmetric Skip Connections |

圖像超分辨率(Super Resolution,SR)是指從低分辨率(Low Resolution,LR)圖像中恢復(fù)高分辨率(High Resolution, HR)圖像的過程,是計算機視覺和圖像處理中一類重要的圖像處理技術(shù)。SR在現(xiàn)實世界中有著廣泛的應(yīng)用,如醫(yī)療成像、監(jiān)控和安全等。除了提高圖像感知質(zhì)量外,SR還有助于改善其他計算機視覺任務(wù)。一般來說,超分辨率分析是非常具有挑戰(zhàn)性的,而且本身就是一個難題,因為總是有多個HR圖像對應(yīng)于一個LR圖像。在已有文獻中,研究人員提出了各種經(jīng)典的SR方法,包括基于預(yù)測的方法、基于邊緣的方法、統(tǒng)計方法、基于patch的方法和稀疏表示方法等。

近年來,隨著深度學(xué)習(xí)技術(shù)的快速發(fā)展,基于深度學(xué)習(xí)的SR模型得到了快速發(fā)展,并在SR的各種基準(zhǔn)上取得了最先進的性能。各種各樣的深度學(xué)習(xí)方法已經(jīng)被應(yīng)用于SR任務(wù),從早期的基于卷積神經(jīng)網(wǎng)絡(luò)(CNN)的方法到最近使用的生成對抗網(wǎng)絡(luò)的SR方法。一般來說,使用深度學(xué)習(xí)技術(shù)的SR方法在以下主要方面有所不同:不同類型的網(wǎng)絡(luò)架構(gòu)、不同類型的損失函數(shù)、不同類型的學(xué)習(xí)原理和策略等。

超分辨率分析可以分為視頻超分辨率VSR(Video Super Resolution) 和單幀超分辨率SISR(Single Image Super Resolution),本文重點關(guān)注單幀超分辨率分析方法。本文聚焦于深度學(xué)習(xí)技術(shù),回顧SISR中必備的TOP模型。

1、 SRCNN

本文首次提出將深度學(xué)習(xí)技術(shù)應(yīng)用于SR,得到經(jīng)典的SRCNN(Super-Resolution CNN)模型。SRCNN結(jié)構(gòu)很簡單,但是效果很好。計算效率高,速度快。對于一個LR圖像,首先使用bicubic 插值到所需的尺寸得到圖像Y,然后學(xué)習(xí)一個映射F,使得F(Y)盡可能和ground-truth接近。該方法的完整學(xué)習(xí)過程包含三步:1)Patch extraction and representation,從Y中提取patches并表示為高維向量;Non-linear mapping,將高維向量映射到另一高維向量;reconstruction,整合上述的high-resolution patch-wise representation。上述三個步驟組成了一個卷積網(wǎng)絡(luò)。如圖1所示:

圖1 給定一個低分辨率的圖像Y,SRCNN的第一個卷積層提取一組特征圖。第二層將這些特征圖非線性地映射到高分辨率的patch表示上。最后一層結(jié)合空間鄰域內(nèi)的預(yù)測,生成最終的高分辨率圖像F (Y)

Patch extraction and representation。在圖像恢復(fù)中有一個常用的策略就是從圖像密集提取圖像塊,然后用一組預(yù)先訓(xùn)練好的基(PCA、DCT、Haar等)來表示。這等同于用一組濾波器對圖像進行卷積,每個濾波器對應(yīng)一個基。SRCNN的第一層可以如下表示:

其中,W1對應(yīng) n1個濾波器,每個濾波器大小為 c×f_1 ×f_1 ,其中,c是圖像通道數(shù),RGB就是3通道,灰度圖像是單通道。f_1是濾波器尺寸。卷積之后就得到n1個特征圖。接著對濾波器響應(yīng)應(yīng)用 ReLU,即 max(0,x)。

Non-linear mapping。經(jīng)過上一步卷積,我們得到一個n1維特征向量,對應(yīng)一個圖像塊,這一步,將一個n1維特征向量映射到一個n2維向量。對于大的濾波器,非線性映射不是對應(yīng)圖像塊,而是對應(yīng)特征圖中的 "塊"。這一步可以看做如下卷積:

Reconstruction。這一步就是對高分辨率圖像塊的權(quán)值平均,這個平均可以看做對一組特征圖的一個預(yù)先定義的濾波器,使用下面的卷積表示:

在SRCNN中,上述三個步驟作為一個卷積網(wǎng)絡(luò)共同訓(xùn)練。

當(dāng)前SOTA!平臺收錄SRCNN共57個模型實現(xiàn)。

項目SOTA!平臺項目詳情頁SRCNN前往 SOTA!模型平臺獲取實現(xiàn)資源:https://sota.jiqizhixin.com/project/srcnn

2、 DRCN

SRCNN的層數(shù)較少,同時感受野也較小(13x13)。本文提出的DRCN (Deeply-Recursive Convolutional Network for Image Super-Resolution)使用更多的卷積層增加網(wǎng)絡(luò)感受野(41x41),同時為了避免過多網(wǎng)絡(luò)參數(shù),使用遞歸神經(jīng)網(wǎng)絡(luò)(RNN)。網(wǎng)絡(luò)的基本結(jié)構(gòu)如圖2,輸入圖像是原始LR圖像經(jīng)過插值上采樣后的圖像。

圖2 DRCN架構(gòu)

與SRCNN類似,DRCN分為三個模塊,第一個是Embedding network,相當(dāng)于特征提取;第二個是Inference network, 相當(dāng)于特征的非線性變換;第三個是Reconstruction network,即從特征圖像得到最后的重建結(jié)果。其中的Inference network是一個遞歸網(wǎng)絡(luò),即數(shù)據(jù)循環(huán)地通過該層多次。將這個循環(huán)展開,就等效于使用同一組參數(shù)的多個串聯(lián)的卷積層。DRCN將每一層的卷積結(jié)果都通過同一個Reconstruction Net得到一個重建結(jié)果,從而共得到D個重建結(jié)果,再把它們加權(quán)平均得到最終的輸出。另外,受到ResNet的啟發(fā),DRCN通過skip connection將輸入圖像與H_d的輸出相加后再作為Reconstruction Net的輸入(如圖2所示),相當(dāng)于使Inference Net去學(xué)習(xí)高分辨率圖像與低分辨率圖像的差,即恢復(fù)圖像的高頻部分。

以上得到的Basic Model 雖然簡單且功能強大,但作者發(fā)現(xiàn)訓(xùn)練深度遞歸網(wǎng)絡(luò)非常困難(最多訓(xùn)練三個循環(huán)層)。作者分析有以下幾點原因:1)梯度的消失和爆炸。梯度爆炸是由鏈?zhǔn)教荻鹊某朔ㄐ再|(zhì)造成的。對于深度遞歸,可以呈指數(shù)增長。梯度消失問題正好與梯度爆炸相反。梯度呈指數(shù)級的速度到零向量。因此,梯度爆炸和消失的存在使深度遞歸網(wǎng)絡(luò)掌握遠距離像素信息間的關(guān)系非常困難。2)經(jīng)過多次遞歸想要保留原始LR信息并不容易。在SR任務(wù)中,輸出與輸入非常相似,所以LR圖像的信息非常重要,需要為后續(xù)更深的遞歸層保留輸入圖像的精確信息。3)存在一個尋找最優(yōu)遞歸次數(shù)的問題。如果遞歸對于給定的任務(wù)來說太深,就需要減少遞歸的次數(shù)。尋找最優(yōu)數(shù)需要訓(xùn)練許多具有不同遞歸深度的網(wǎng)絡(luò)。

由此,作者提出了如下改進技術(shù):1)Recursive-Supervision:監(jiān)督每層遞歸,以減輕梯度消失/爆炸的影響。假設(shè)在推理層中卷積過程反復(fù)使用相同的卷積核,使用相同的重建層來預(yù)測每一次遞歸重建的SR圖像。重建層輸出D個預(yù)測圖像,所有預(yù)測都在訓(xùn)練期間同時受到監(jiān)督。將所有D個預(yù)測圖像通過加權(quán)求和來計算最終輸出(權(quán)重由網(wǎng)絡(luò)學(xué)習(xí)得到)。通過遞歸減輕了訓(xùn)練遞歸網(wǎng)絡(luò)的困難,通過反向傳播將不同預(yù)測損失產(chǎn)生的反傳梯度求和提供平滑效果,能夠有效緩解梯度爆炸或消失。此外,由于監(jiān)督能夠利用所有中間層的預(yù)測信息,因此,對最佳遞歸次數(shù)選擇的重要性降低了。2)Skip-Connection:對于圖像重建任務(wù),輸入和輸出圖像高度相關(guān),所以可以直接通過skip層連接將LR信息直接傳輸?shù)絊R重建層。改進后的Advanced Model如圖3所示。

圖3 (a): Advanced Model,帶有遞歸監(jiān)督和skip connection。重建網(wǎng)絡(luò)是共享的,用于遞歸預(yù)測。使用中間遞歸的所有預(yù)測來獲得最終的輸出。(b): 將深度監(jiān)督應(yīng)用于Basic Model。與(a)不同的是,(b)中的模型使用不同的重建網(wǎng)絡(luò)進行遞歸,并且使用了更多的參數(shù)。(c): (a)的擴展結(jié)構(gòu)示例,沒有參數(shù)共享(沒有遞歸)。權(quán)重參數(shù)的數(shù)量與深度的平方成正比

當(dāng)前SOTA!平臺收錄DRCN共1個模型實現(xiàn)。

項目SOTA!平臺項目詳情頁DRCN前往 SOTA!模型平臺獲取實現(xiàn)資源:https://sota.jiqizhixin.com/project/drcn

3、FSRCNN

本文旨在加速SRCNN,提出了一個compact hourglass-shape 的CNN結(jié)構(gòu)--FSRCNN,主要在三個方面進行了改進:1)在整個模型的最后使用了一個反卷積層放大尺寸,因此可以直接將原始的低分辨率圖像直接輸入到網(wǎng)絡(luò)中,而不需要像SRCNN一樣先通過bicubic方法放大尺寸。2)改變特征維數(shù),使用更小的卷積核和使用更多的映射層。3)可以共享其中的映射層,如果需要訓(xùn)練不同上采樣倍率的模型,只需要fine-tuning最后的反卷積層。

由于FSRCNN不需要在網(wǎng)絡(luò)外部進行放大圖像尺寸的操作,同時通過添加收縮層和擴張層,將一個大層用一些小層來代替,因此FSRCNN與SRCNN相比有較大的速度提升。FSRCNN在訓(xùn)練時也可以只fine-tuning最后的反卷積層,因此訓(xùn)練速度也更快。FSRCNN與SCRNN的結(jié)構(gòu)對比如圖4所示。

圖4 該圖顯示了SRCNN和FSRCNN的網(wǎng)絡(luò)結(jié)構(gòu)。FSRCNN主要在三個方面與SRCNN不同。首先,F(xiàn)SRCNN采用原始的低分辨率圖像作為輸入,沒有進行雙三次插值。在網(wǎng)絡(luò)的末端引入了一個解卷積層來進行上采樣。第二,SRCNN中的非線性映射步驟被FSRCNN中的三個步驟所取代,即收縮、映射和擴展步驟。第三,F(xiàn)SRCNN采用了更小的濾波器尺寸和更深的網(wǎng)絡(luò)結(jié)構(gòu)

FSRCNN的結(jié)構(gòu)如圖4下半部分所示。整個網(wǎng)絡(luò)可以被分解為5個部分:特征提取、壓縮、映射、擴展、反卷積。其中前四部分都是卷積層conv(fi,ni,ci),第五部分是反卷積層deconv(fi,ni,ci),其中,fi,ni,ci分別為核尺寸、核數(shù)量、核通道。作者將網(wǎng)絡(luò)中的變量分為敏感變量和不敏感變量(敏感是指微小改變即可對網(wǎng)絡(luò)結(jié)果造成很大影響),其中不敏感變量可以預(yù)設(shè),而敏感變量則需根據(jù)實驗比較得出其值。

特征提取:這部分是和SRCNN相似的,不同點在于FSRCNN不經(jīng)過對LR圖像的插值,而是直接從LR圖像提取子圖塊信息。若輸入圖像為灰度圖像,則核深度為1,而核的數(shù)量決定了該層卷積輸出的特征圖的維度d。后續(xù)會將特征圖送入真正的SR過程,所以維度d至關(guān)重要,d是第一個敏感變量,需要實驗對比得出。該層可記為conv(5,d,1)。

壓縮:這部分主要考慮到SRCNN中直接在高維特征圖上對LR做SR,先對LR圖像通道數(shù)進行減小,然后在低維LR特征圖進行SR操作,這樣會減少運算參數(shù),最后再對生成的SR圖像進行升維操作。使用s個1 X 1 大小的濾波核,對來自特征提取層的d維圖像進行降維處理(從d降到s),s是第二個敏感變量,這可以為后續(xù)的SR操作減少參數(shù)量。該層可記為conv(1,s,d)。

非線性映射:這部分最重要的兩個參數(shù)為特征圖的通道數(shù)(d,即核的數(shù)量)和深度(卷積層的層數(shù)m,m是第三個敏感變量),深度m決定了SR的精度和復(fù)雜度。卷積核的尺寸為3X3,因此該部分可記為mXconv(3,s,s)。

擴展:擴展部分使用d個1X1大小的核,以期恢復(fù)到壓縮前的圖像形狀。壓縮、非線性映射、擴展這三部分是對稱的。擴展部分可記為conv(1,d,s)。

反卷積:可視為卷積的逆操作,可以將小尺寸的圖像恢復(fù)成大尺寸的圖像。參照圖5,通過在deconv前移動一個步長,得到deconv后移動的兩個步長的區(qū)域,這樣就可以實現(xiàn)對圖像放大2倍的操作了。為了保持對稱結(jié)構(gòu),需要采用9X9大小的濾波器。該層可記為deconv(9,1,d)。反卷積不同于傳統(tǒng)的插值方法,傳統(tǒng)的方法對所有的重建像素都有一套共同的重建公式,而反卷積的核需要學(xué)習(xí)得到,它能夠針對具體的任務(wù)得出更精確的結(jié)果。

圖5 FSRCNN由卷積層和反卷積層組成

PReLU:直接給出公式f(xi) = max(xi,0) + ai*min(0,xi),在原來relu 的基礎(chǔ)上,對負半軸的梯度也能激活(即使很小),消除了部分梯度無法激活的情況。

全局結(jié)構(gòu):Conv(5, d, 1) - PReLU - Conv(1, s, d)-PReLU - m×Conv(3, s, s) - PReLU-Conv(1, d, s) - PReLU - DeConv(9, 1, d)。從全局來看,有三個參數(shù)d、s、m影響著網(wǎng)絡(luò)的性能和速度,所以將網(wǎng)絡(luò)記為FSRCNN(d,s,m),計算復(fù)雜度可由下式表示:

當(dāng)前SOTA!平臺收錄FSRCNN共8個模型實現(xiàn)。

項目SOTA!平臺項目詳情頁

FSRCNN

前往 SOTA!模型平臺獲取實現(xiàn)資源:https://sota.jiqizhixin.com/project/fsrcnn4、ESPCN

在SRCNN和DRCN中,低分辨率圖像都是先通過上采樣插值得到與高分辨率圖像同樣的大小,再作為網(wǎng)絡(luò)輸入,意味著卷積操作在較高的分辨率上進行,相比于在低分辨率的圖像上計算卷積,會降低效率。本文提出一種在低分辨率圖像上直接計算卷積得到高分辨率圖像的高效率亞像素卷積神經(jīng)網(wǎng)絡(luò)(efficient sub-pixel convolutional neural network,ESPN)。

圖6. ESPN有兩個卷積層用于提取特征圖,還有一個亞像素卷積層將LR空間的特征圖聚合起來,并在一個步驟中建立SR圖像

ESPN的核心概念是亞像素卷積層(sub-pixel convolutional layer)。如上圖所示,網(wǎng)絡(luò)的輸入是原始低分辨率圖像,通過兩個卷積層以后,得到的特征圖像大小與輸入圖像一樣,但是特征通道數(shù)量為r^2(r是圖像的目標(biāo)放大倍數(shù))。將每個像素的r^2個通道重新排列成一個r x r的區(qū)域,對應(yīng)于高分辨率圖像中的一個r x r大小的子塊,從而將大小為r^2 x H x W的特征圖像重新排列成1 x rH x rW大小的高分辨率圖像。這個變換雖然被稱作sub-pixel convolution, 但實際上并沒有卷積操作。通過使用sub-pixel convolution, 在將圖像從低分辨率到高分辨率放大的過程中,插值函數(shù)被隱含地包含在前面的卷積層中,可以自動學(xué)習(xí)而得到。只在最后一層對圖像大小做變換,前面的卷積運算由于在低分辨率圖像上進行,因此效率會較高。

首先將一個l層卷積神經(jīng)網(wǎng)絡(luò)直接應(yīng)用于LR圖像,然后利用一個子像素卷積層將LR特征圖放大,生成SR圖像I^。對于一個由L層組成的網(wǎng)絡(luò),前L-1層可以描述如下:

在LR空間中,一個跨度為1/r的卷積與一個大小為ks、權(quán)重間隔為1/r的濾波器Ws進行卷積,能夠激活Ws的不同部分。落在像素之間的權(quán)重沒有被激活,不需要計算。激活模式的數(shù)量正好是r^2。每個激活模式,根據(jù)其位置,最多有[ks/r]^2個權(quán)重被激活。在整個圖像的濾波卷積過程中,根據(jù)不同的子像素位置,這些模式被周期性地激活:mod (x,r)、 mod (y,r) w,其中x,y是HR空間中的輸出像素坐標(biāo)。本文提出了一種有效的方法來實現(xiàn)上述操作,當(dāng)mod(ks,r)=0時:

因此卷積算子W_L具有n_L-1×r^2C×k_L×k_L的形狀。請注意,我們不對最后一層的卷積的輸出施加非線性約束。當(dāng)k_L = k_s/r和mod (k_s, r) = 0時,它等同于LR空間中的子像素卷積。將新層稱為亞像素卷積層,由此,網(wǎng)絡(luò)稱為高效亞像素卷積神經(jīng)網(wǎng)絡(luò)(ESPN)。最后一層從LR特征圖中直接生成HR圖像,每個特征圖都有一個放大的濾波器。

最終ESPN網(wǎng)絡(luò)目標(biāo)函數(shù)為:

當(dāng)前SOTA!平臺收錄ESPCN共14個模型實現(xiàn)。

項目SOTA!平臺項目詳情頁ESPCN前往 SOTA!模型平臺獲取實現(xiàn)資源:https://sota.jiqizhixin.com/project/espcn

5、 SRGAN

深度卷積神經(jīng)網(wǎng)絡(luò)在單個圖像實現(xiàn)超分辨率在速度和精度上取得了突破,但是仍然存在一個核心問題:當(dāng)在放大因子下的超分辨率時,如何恢復(fù)細小的紋理細節(jié)?基于這些問題:本文提出了一種用于圖像SR的生成對抗網(wǎng)絡(luò)SRGAN(Super-Resolution Using a Generative Adversarial Network),并且根據(jù)GAN網(wǎng)絡(luò)結(jié)構(gòu)提出了一種新的視覺損失( perceptual loss),其中包含對抗損失(adversarial loss)和內(nèi)容損失(content loss)。

圖7. SRGAN的生成器和鑒別器網(wǎng)絡(luò)結(jié)構(gòu),每個卷積層都有相應(yīng)的核大小(k)、特征圖數(shù)量(n)和步長(s)

如圖7所示網(wǎng)絡(luò)結(jié)構(gòu),在訓(xùn)練SRGAN的生成器網(wǎng)絡(luò)過程中需要提供HR圖像。首先對HR圖像進行下采樣得到相應(yīng)的LR圖像,然后將LR圖像作為生成器的輸入,訓(xùn)練生成器,使之輸出對應(yīng)的HR圖像。作者提出用深度殘差網(wǎng)絡(luò)(ResNet)作為生成器的生成對抗網(wǎng)絡(luò),網(wǎng)絡(luò)結(jié)構(gòu)中存在很多的skip connection。為了區(qū)分真實的HR圖像和生成的HR圖像,還訓(xùn)練了一個鑒別器,使用了LeakeyReLU作為激活函數(shù),網(wǎng)絡(luò)層數(shù)從64到512,后面連接兩個全連接層和一個sigmoid層,用來判斷是否為同一圖像的概率。

文章將代價函數(shù)改進為:

第一部分是基于內(nèi)容的代價函數(shù),第二部分是基于對抗學(xué)習(xí)的代價函數(shù)。基于內(nèi)容的代價函數(shù)除了像素空間的最小均方差以外,又包含了一個基于特征空間的最小均方差,該特征是利用VGG網(wǎng)絡(luò)提取的圖像高層次特征:

對抗學(xué)習(xí)的代價函數(shù)是基于鑒別器輸出的概率:

當(dāng)前SOTA!平臺收錄SRGAN共5個模型實現(xiàn)。

項目SOTA!平臺項目詳情頁SRGAN前往 SOTA!模型平臺獲取實現(xiàn)資源:https://sota.jiqizhixin.com/project/srgan

6、 Red

本文提出了一個由對稱的卷積層——反卷積層構(gòu)成的網(wǎng)絡(luò)結(jié)構(gòu),稱為Red-Net(Residual Encoder-Decoder Networks)。如圖8所示,其網(wǎng)絡(luò)結(jié)構(gòu)是對稱的,每個卷積層都對應(yīng)有反卷積層,卷積層將輸入圖像尺寸減小后,再通過反卷積層上采樣變大,使得輸入輸出的尺寸一樣。卷積層用于提取圖像的特征,相當(dāng)于編碼的作用。而反卷積層用于放大特征的尺寸并恢復(fù)圖像細節(jié)。每一組鏡像對應(yīng)的卷積和反卷積都由skip connection將兩部分具有同樣尺寸的特征進行相加操作后再輸入到下一個反卷積層。這樣的結(jié)構(gòu)能夠讓反向傳播信號能夠直接傳遞到底層,解決了梯度消失問題,同時能將卷積層的細節(jié)傳遞給反卷積層,從而恢復(fù)出更干凈的圖像。與此同時,網(wǎng)絡(luò)中有一條線是將輸入的圖像連接到后面與最后的一層反卷積層的輸出相加,因此,整個模型架構(gòu)中間的卷積層和反卷積層學(xué)習(xí)的特征是目標(biāo)圖像和低質(zhì)圖像之間的殘差。

圖8.網(wǎng)絡(luò)整體結(jié)構(gòu)。該網(wǎng)絡(luò)包含對稱卷積(編碼器)和反卷積(去編碼器)層。每隔幾層(在本文實驗中是兩層)就有一個skip shortcuts,從卷積特征圖到其鏡像的反卷積特征圖。卷積層的響應(yīng)被直接傳播到相應(yīng)的鏡像反卷積層,包括前向和后向傳播

具體來說,各個組成部分的作用如下:

卷積:特征提取,隨卷積進行,提取圖像特征同時抑制噪聲,經(jīng)過多層卷積后,提取圖像特征,同時降低噪聲的影響。

反卷積:針對特征的上采樣,完成由圖像特征到圖像的轉(zhuǎn)換,由于利用的是過濾噪聲后的圖像特征,因此達到了降噪、圖像修復(fù)的目的。

Skip connections:保留更多的圖像細節(jié),協(xié)助反卷積層完成圖像的恢復(fù)工作;反向傳播過程中的梯度反向,減少梯度消失,加快模型訓(xùn)練。

當(dāng)前SOTA!平臺收錄RED共16個模型實現(xiàn)。

項目SOTA!平臺項目詳情頁RED前往 SOTA!模型平臺獲取實現(xiàn)資源:https://sota.jiqizhixin.com/project/red30-2

前往 SOTA!模型資源站(sota.jiqizhixin.com)即可獲取本文中包含的模型實現(xiàn)代碼、預(yù)訓(xùn)練模型及API等資源。

網(wǎng)頁端訪問:在瀏覽器地址欄輸入新版站點地址sota.jiqizhixin.com,即可前往「SOTA!模型」平臺,查看關(guān)注的模型是否有新資源收錄。

移動端訪問:在微信移動端中搜索服務(wù)號名稱「機器之心SOTA模型」或 ID「sotaai」,關(guān)注 SOTA!模型服務(wù)號,即可通過服務(wù)號底部菜單欄使用平臺功能,更有最新AI技術(shù)、開發(fā)資源及社區(qū)動態(tài)定期推送。

-

明日!A股將迎重磅變化

頭條 23-04-09

-

天天熱頭條丨今年正式推出蝦尾“新品”,這家企業(yè)何以敢闖入一片紅海?丨“豫制菜”上新季

頭條 23-04-09

-

視訊!肉醬汁遇上Q彈意面,必勝客致力打造家中的西餐廳|“豫制菜”上新季

頭條 23-04-09

-

環(huán)球速訊:通威股份一季度凈利超80億元,同比增長約60%-68%

頭條 23-04-09

-

業(yè)績翻倍!億緯鋰能預(yù)計一季度盈利10.42億~11.47億元

頭條 23-04-09

-

【天天熱聞】扭虧為盈,華蘭疫苗預(yù)計一季度盈利超8600萬元

頭條 23-04-09

-

業(yè)績大漲超268%!新開源預(yù)計一季度盈利1.2億~1.4億元|世界快報

頭條 23-04-09

-

前沿資訊!中央決定:免去劉祥民中國鋁業(yè)集團總經(jīng)理等職務(wù)

頭條 23-04-09

-

每日速訊:中央決定:免去遲京濤中儲糧總經(jīng)理等職務(wù)

頭條 23-04-09

-

最美人間四月天!“財金先生”組團開跑鄭州龍湖馬拉松

頭條 23-04-09

-

突然爆了!林俊杰巨虧90%?這個市場徹底崩盤!此前更有爆倉傳聞 熱議

頭條 23-04-09

-

新市民金融服務(wù)專場再啟!河南省線上常態(tài)化銀企對接周一見|環(huán)球快看點

頭條 23-04-09

-

回鍋肉、香鹵肥腸,眾品食業(yè)預(yù)制菜等你嘗鮮丨“豫制菜”上新季 全球微頭條

頭條 23-04-09

-

每日焦點!醬味香濃醇厚、香辣誘人,福香居香辣麻醬等你聞香嘗鮮丨“豫制菜”上新季

頭條 23-04-09

-

焦點速遞!火力全開!螞蟻商聯(lián)預(yù)制燒烤食材等你嘗鮮 |“豫制菜”上新季

頭條 23-04-09

-

總投資20億元,海立·海爾合資壓縮機鄭州生產(chǎn)基地開建_焦點速讀

頭條 23-04-09

-

百度突發(fā)聲明:起訴!

頭條 23-04-09

-

世界速遞!內(nèi)幕交易還加杠桿!水利部一副局長被查,盈利50萬,其妻也被罰

頭條 23-04-09

-

“國字號”產(chǎn)業(yè)轉(zhuǎn)移對接活動6月在豫舉行

頭條 23-04-09

-

世界熱消息:罕見!“父子反目”,公章不還?最新進展來了

頭條 23-04-08

-

每日看點!腌篤鮮、椒蒜肥腸新“鮮”來襲,盒馬預(yù)制春菜已上架丨“豫制菜”上新季

頭條 23-04-08

-

佳沃食品凈資產(chǎn)為負遭ST,聯(lián)想控股食品板塊受挫

頭條 23-04-08

-

焦點短訊!從微波爐到空氣炸鍋,三全食品打造預(yù)制菜新場景丨“豫制菜”上新季

頭條 23-04-08

-

豆腐玩出新花樣,李家寨預(yù)制豆制品等你嘗鮮丨“豫制菜”上新季

頭條 23-04-08

-

世界速讀:中原農(nóng)谷“一核三區(qū)”,手中都有啥王牌?丨探秘中原農(nóng)谷③

頭條 23-04-08

-

請河南食企來賣菜!丹尼斯、京東、盒馬的采購商到齊|全球快資訊

頭條 23-04-08

-

信陽市市級河長名單公布|天天聚看點

頭條 23-04-08

-

動態(tài)焦點:盛紹成任舞鋼市副市長

頭條 23-04-08

-

全球觀天下!800億巨頭總裁突然辭職

頭條 23-04-08

-

百度發(fā)打假聲明!已對蘋果公司及相關(guān)開發(fā)者團隊發(fā)起訴訟 今亮點

頭條 23-04-08

-

擬發(fā)行金額2.17億元,平煤神馬供應(yīng)鏈ABS獲深交所通過 天天微資訊

頭條 23-04-08

-

吉利控股集團與山東3家省屬企業(yè)簽約,將在新能源汽車示范等領(lǐng)域合作 每日簡訊

頭條 23-04-08

-

全球看點:湖南新謀劃的4個萬億級新興產(chǎn)業(yè),都有哪些?

頭條 23-04-08

-

林毅夫:不要低估中國經(jīng)濟潛力_今日播報

頭條 23-04-08

-

平煤神馬集團:推進集團首批15家“專精特新”企業(yè)上市|熱點

頭條 23-04-08

-

震動A股!康美實業(yè)破產(chǎn),昔日800億造假主角徹底出局?

頭條 23-04-08

-

爆雷房企退市潮來了?新力控股退市,藍光發(fā)展發(fā)布退市風(fēng)險警示

頭條 23-04-07

-

中國儲備糧管理集團總經(jīng)理調(diào)整 環(huán)球焦點

頭條 23-04-07

-

天天微資訊!馬上消費金融2022年盈利17.88億元,同比增長29.34%

頭條 23-04-07

-

當(dāng)前通訊!418項!武漢公布2023年市級重大項目清單

頭條 23-04-07

-

環(huán)球資訊:仲景食品2022年年報出爐:擬分紅1億元,大單品香菇醬銷售額超3億元

頭條 23-04-07

-

洛陽市政協(xié)經(jīng)濟委員會副主任王現(xiàn)利主動投案

頭條 23-04-07

-

固佳食品預(yù)制菜上新,固佳雞湯最“出圈”丨“豫制菜”上新季

頭條 23-04-07

-

快訊!上市公司惠豐鉆石擬更名

頭條 23-04-07

- SRCNN、DRCN、FSRCNN、ESPCN、SRGAN、RED 2023-04-09

- 涼 · 快 TREK VELOCIS 頭盔評測2023-04-09

- “安排保安 24 小時騷擾你!”小廣告鬧心2023-04-09

- 每日關(guān)注!龍湖:古鎮(zhèn)煥發(fā)文旅新活力2023-04-09

- 對臺島西南目標(biāo)全時追瞄 東部戰(zhàn)區(qū)持續(xù)保持2023-04-09

- 對臺島西南目標(biāo)全時追瞄 東部戰(zhàn)區(qū)持續(xù)保持2023-04-09

- 全球速讀:美國本土以外首個特斯拉儲能超級2023-04-09

- 男子駕車沖撞致3死7傷,警方通報:嫌犯已被2023-04-09

- 47歲男子因感情糾紛駕車沖撞48歲女子,致32023-04-09

- 明日!A股將迎重磅變化2023-04-09

- 快報:中央氣象臺:北方地區(qū)將有大風(fēng)沙塵天2023-04-09

- 今起北方大部將遭風(fēng)沙侵襲 局地有強沙塵暴2023-04-09

- 雷暴大風(fēng)或冰雹!中央氣象臺:吉林河北山東2023-04-09

- 環(huán)球觀天下!生機無限 呼倫貝爾迎大批遷徙2023-04-09

- 每日熱議!別錯過!市區(qū)戶口外地返鄭考生信2023-04-09

- 河南隊主場票務(wù)工作開始啟動-天天速看2023-04-09

- 世界速看:2023年上海長寧區(qū)社區(qū)工作者公開2023-04-09

- 廈門肛泰腸醫(yī)院評價!透明化管理讓消費者放2023-04-09

- 常青科技:募資加碼研發(fā)創(chuàng)新,推動核心技術(shù)2023-04-09

- 空氣污染嚴重,泰國清邁發(fā)布“居家辦公令”2023-04-09

- 成都升溫千足蟲滿街爬?專家:是馬陸,可能2023-04-09

- 美國本土以外首個特斯拉儲能超級工廠項目正2023-04-09

- 兩艘偷渡船在突尼斯海域沉沒,27人死亡或失2023-04-09

- 環(huán)球今頭條!中國新一批地震救援物資抵達敘2023-04-09

- 動態(tài)焦點:中攀聯(lián)賽武漢站速度冠軍誕生!獲2023-04-09

- 天天熱頭條丨今年正式推出蝦尾“新品”,這2023-04-09

- 精彩看點:北京連發(fā)大風(fēng)、沙塵藍色預(yù)警!西2023-04-09

- 當(dāng)前觀點:武警部隊來私人飯館訂餐?民警:2023-04-09

- 楊柳絮+浮塵揚沙來了!安徽的“救場”降雨2023-04-09

- 環(huán)球消息!突然大漲!銷量“狂飆”!再掀“2023-04-09

精彩推薦

閱讀排行

- 環(huán)球聚焦:WTT新鄉(xiāng)冠軍賽開幕 馬龍陳夢首日出戰(zhàn)

- 世界熱消息:古墓里睡覺,文物間尋寶?洛陽1688元夜宿古墓博物館“劇本殺”首批體驗者曬視頻

- 大象幫|生態(tài)文化公園仿佛“二手車市場”,治理游園停車亂,還需打出“組合拳” 全球快資訊

- 全球消息!2023鄭州龍湖半程馬拉松賽開賽

- 天天熱文:實探天門山涉事玻璃棧道恢復(fù)正常,家屬稱警方透露服毒量遠超致死水平

- 每日觀點:張家界跳崖離世女子親友:警方透露4人群聊“約死” 遺書內(nèi)容相同

- 世界頭條:“丫丫”回家時間定了!山東非遺傳承人制作泥塑迎接丫丫

- 焦點簡訊:鄭州住房公積金調(diào)整政策 支持租房提取和剛需購房

- 世界快訊:久違了,嗨起來!2023鄭開馬拉松賽4月16日鳴槍開賽!

- 電影《親愛的》原型孫海洋講述尋子14年